流式數據處理在數據工廠的應用與實踐 以北京軟件開發為例

在當今大數據時代,數據的價值與其時效性緊密相關。北京作為中國的科技創新中心,其軟件開發產業正以前所未有的速度發展,對實時數據處理的需求日益迫切。數據工廠作為數據集成、處理與服務的核心平臺,引入流式數據處理技術,已成為北京眾多軟件企業提升競爭力、驅動業務創新的關鍵實踐。

一、 流式數據處理的核心價值

流式數據處理是一種對持續生成的數據流進行實時或近實時處理的計算模式。與傳統的批處理相比,其核心優勢在于 低延遲 和 高實時性。在北京的軟件開發場景中,這意味著能夠即時響應用戶行為、監控系統狀態、捕捉市場動態,從而支持實時推薦、風險控制、物聯網監控、運維告警等關鍵業務。

二、 數據工廠中的流式處理架構實踐

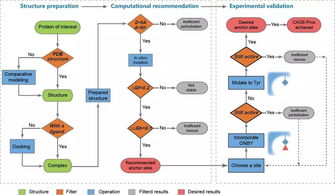

在北京領先的軟件公司數據工廠中,流式數據處理的典型架構通常包含以下層次:

- 數據采集層: 通過 Apache Kafka、Pulsar(尤其在北京的互聯網公司中應用廣泛)等消息隊列,從各類應用、日志、傳感器中持續采集高吞吐量的數據流。

- 流處理引擎層: 采用 Apache Flink(因其優秀的狀態管理和 Exactly-Once 語義在北京業界備受青睞)、Spark Streaming 或 Storm 作為計算核心。這些引擎在數據工廠中負責進行實時ETL(提取、轉換、加載)、窗口聚合、復雜事件處理(CEP)及實時機器學習模型推理。

- 存儲與服務層: 處理后的結果被實時寫入如 Apache Druid、ClickHouse(用于實時OLAP分析),或 HBase、Redis(用于快速查詢服務),最終通過API或數據服務門戶提供給下游的實時報表、運營大屏及業務系統。

三、 在北京軟件開發中的典型應用場景

- 實時用戶行為分析與個性化推薦: 電商、內容平臺通過流處理實時分析用戶的點擊、瀏覽、搜索行為,在毫秒級更新用戶畫像,并驅動推薦引擎調整策略,顯著提升用戶體驗與轉化率。

- 金融風控與交易監控: 北京的金融科技公司利用流處理技術,對每筆交易進行實時模式識別和欺詐檢測,在風險發生前即時攔截,保障資金安全。

- 物聯網(IoT)與智能運維: 在智慧城市、工業互聯網項目中,海量設備傳感器數據流入數據工廠,進行實時異常檢測、預測性維護和資源調度優化。

- 實時數據倉庫與指標計算: 替代傳統的T+1報表,核心業務指標(如GMV、DAU、系統成功率)得以秒級更新,賦能管理者進行實時決策。

四、 實踐挑戰與應對策略

北京的開發團隊在實踐中也面臨諸多挑戰:

- 數據一致性保障: 采用 Flink 的檢查點(Checkpoint)機制和兩階段提交(2PC)連接器,確保端到端的精確一次(Exactly-Once)處理語義。

- 系統高可用與彈性伸縮: 在云原生環境下,利用 Kubernetes 對流處理作業進行容器化部署和管理,實現故障自動恢復和資源的動態伸縮,以應對業務峰谷。

- 流批一體與數據治理: 構建統一的流批一體數據處理架構(如 Flink + Hudi/Iceberg),確保實時數據與歷史數據口徑一致。將數據血緣、質量監控嵌入流處理管道,實現實時數據的可信與可管理。

五、 未來展望

隨著5G、邊緣計算的深化,數據產生的速度和體量將再上新臺階。北京軟件開發的先行者們,正積極探索將流處理能力下沉至邊緣側,并與數據湖、數據編織(Data Fabric)等概念結合,構建更智能、更自治的實時數據工廠。流式數據處理已不僅是技術選項,更是北京軟件產業在數字化浪潮中保持敏捷與創新的基礎設施。

如若轉載,請注明出處:http://www.ztgdled.com/product/44.html

更新時間:2026-02-19 03:49:39